深度学习技术作为AI的重要引擎,近年来受到广泛关注和飞速发展。图神经网络(Graph Neural Network)是一种较新的深度学习技术,可用于处理更复杂的非结构化数据,广泛应用于社交网络、电子购物、药物预测、人机交互等应用场景。随着数据量的急速膨胀,传统CMOS数字硬件系统中运行图神经网络的效率急待提升,图神经网络的训练过程日趋复杂使得训练能耗居高不下。基于阻变忆阻器(RRAM)的存内计算技术虽可显著缓解传统数字硬件系统中的冯·诺依曼瓶颈、进一步提升计算效率,但仍受到高擦写功耗、延时及一定的编程阻值随机性等器件非理想特性的限制。

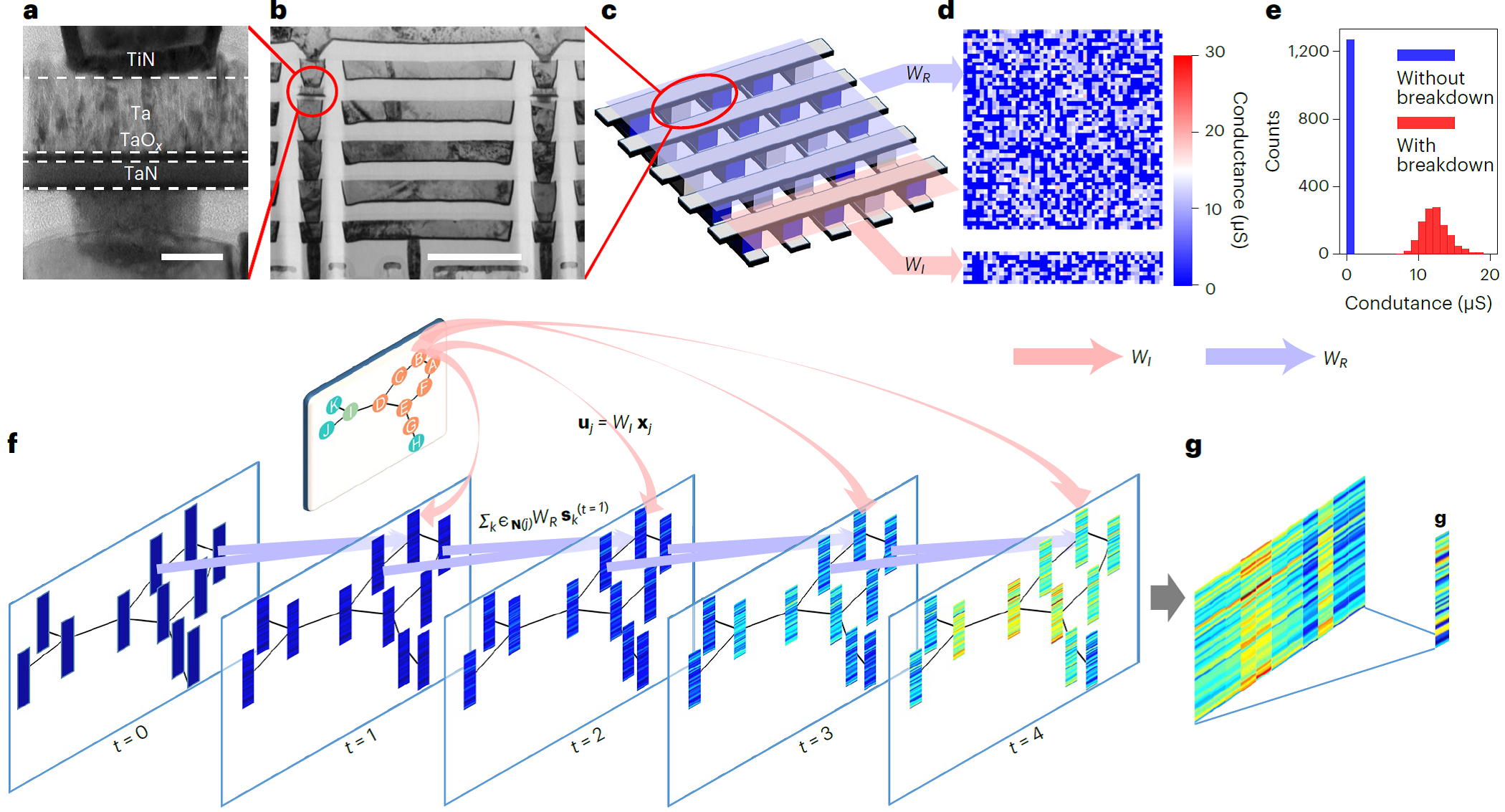

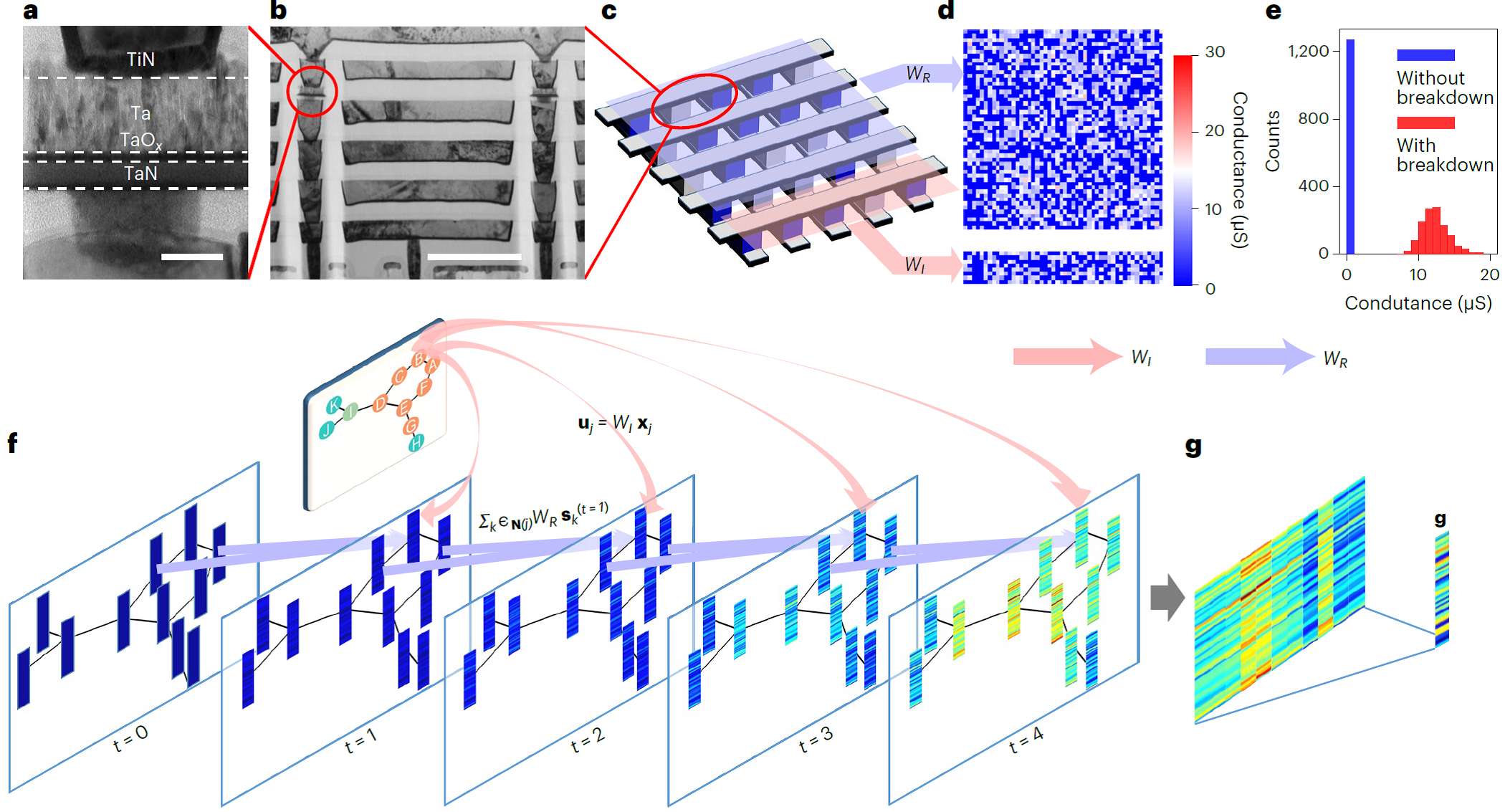

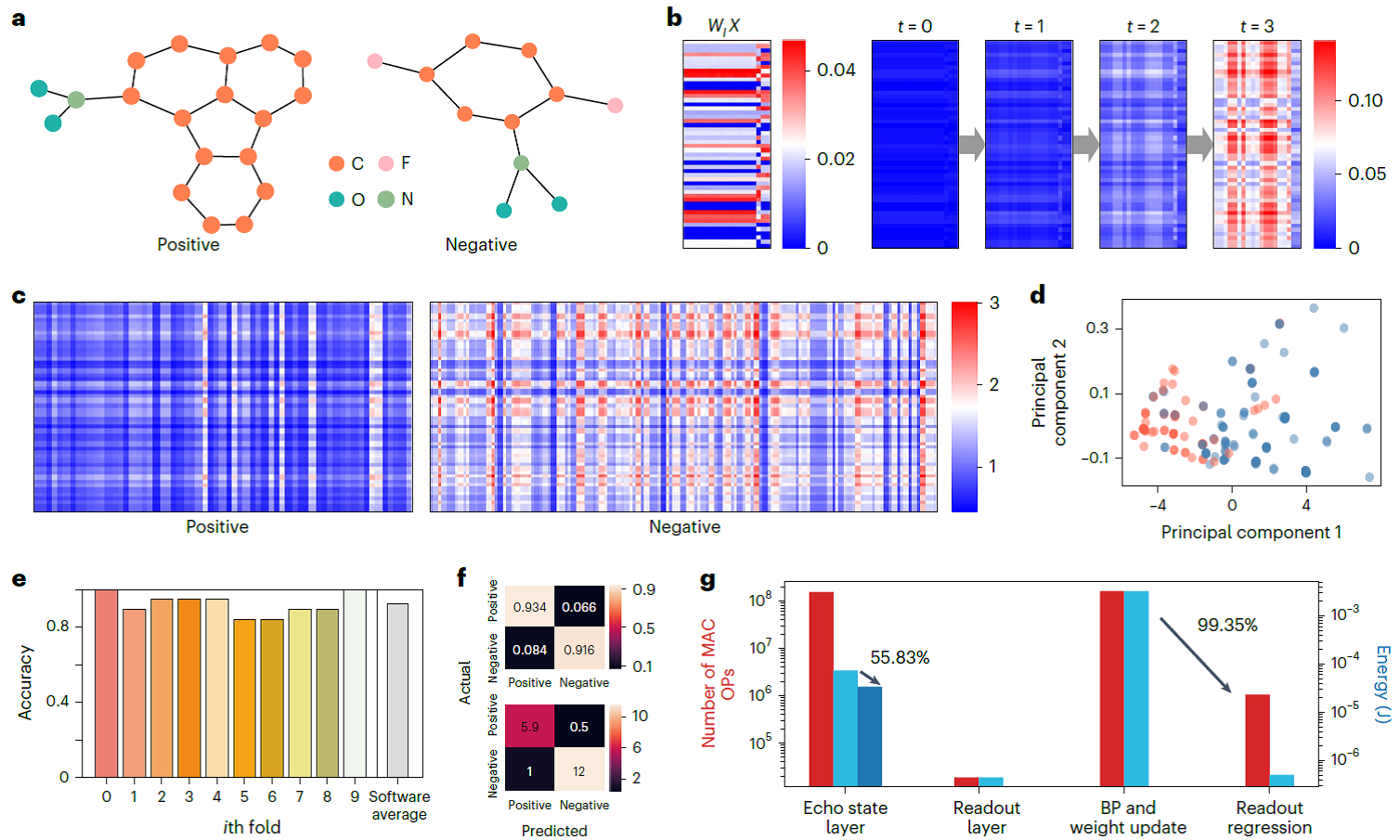

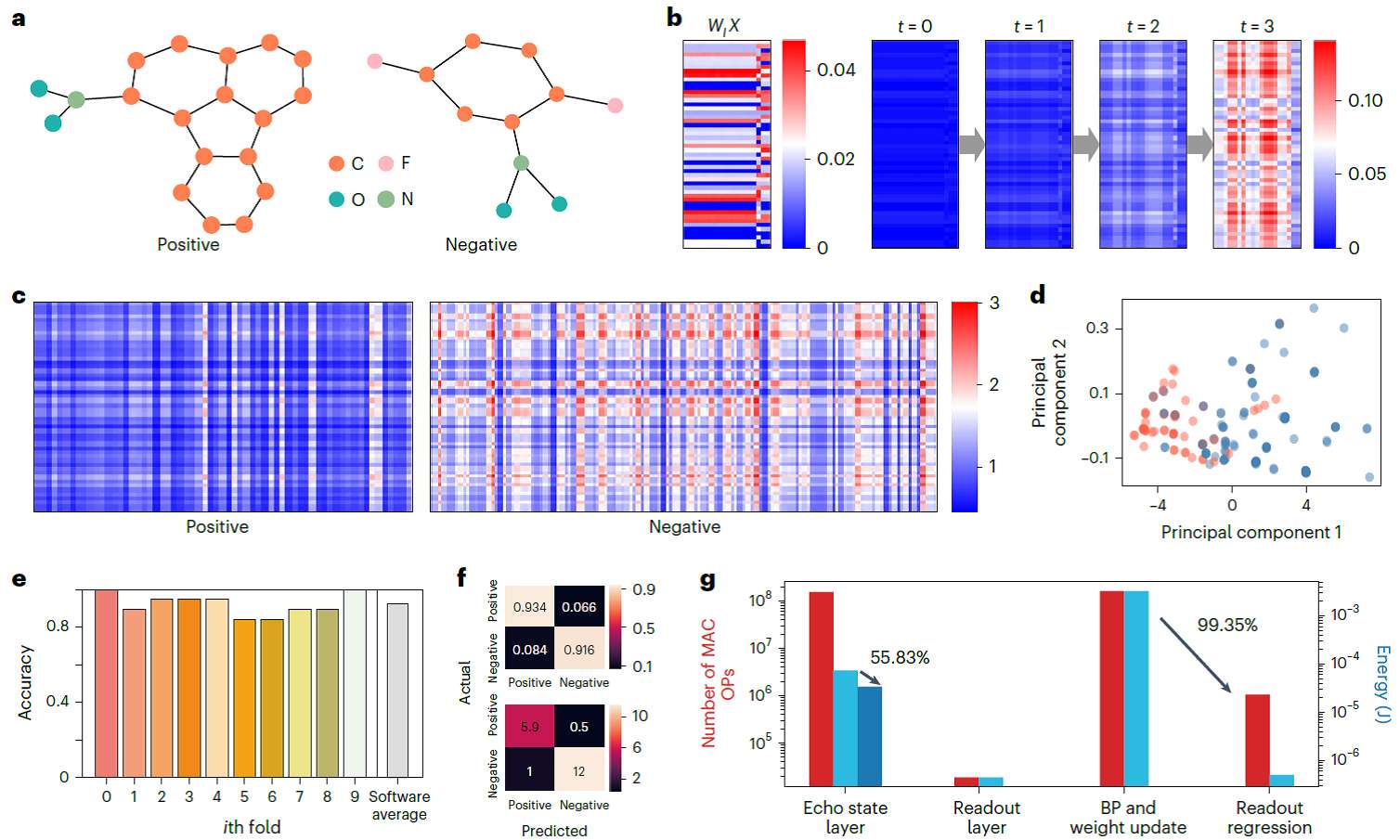

针对上述问题,微电子所微电子器件与集成技术重点实验室刘明院士团队尚大山研究员与香港大学电子工程系王中锐博士合作,开发了一种利用储池计算(Reservoir Computing)技术实现图结构化数据分类的技术——回声状态图网络(ESGNN)。储池计算是循环神经网络的一种简化形式,能够将时序输入信号通过神经元的非线性激活函数转换到一个高维空间中,再通过一个简单线性回归方法有效地读出。储池计算中循环连接层的权重始终固定不变,只需训练输出层权重,可最大限度降低训练复杂度和训练时间。在硬件方面,团队利用RRAM的本征随机性构建大规模随机电阻阵列(图1a-b),将其作为储池网络的初始化权重,具有低成本、可扩展优势。在软件方面,ESGNN巧妙运用了随机电阻阵列带来的物理随机投影,以存内计算的方式完成图嵌入过程,大大降低了图神经网络的训练成本。团队还通过软—硬协同优化技术,在基于FPGA的板级测试平台上实现了对MUTAG、COLLAB数据集的图分类,进行了更大规模CORA数据集的节点分类仿真。相比传统数字硬件系统,能效分别提升了2.16、35.42和40.37倍。该工作展现了RRAM阵列在构建边缘图学习系统方面的巨大潜力,也为利用自然界丰富的物理、化学性质开发更高效的智能硬件系统提供了参考。

该项目得到了科技部、国家自然科学基金委、中科院和香港大学的支持。成果近期发表在《自然·机器智能》期刊上(Nature Machine Intelligence, DOI: 10.1038/s42256-023-00609-5),并入选当期封面文章。微电子所访问学生、香港大学博士研究生王少聪、微电子所博士研究生李熠为文章的共同第一作者,香港大学王中锐博士、微电子所尚大山研究员为该文章的通讯作者。此外,参与本工作的主要研究人员还包括微电子所许晓欣研究员、复旦大学刘琦教授和张续猛博士、浙江大学林芃教授、意大利比萨大学Gallicchio博士和香港科技大学郑光廷教授等。

文章链接:https://www.nature.com/articles/s42256-023-00609-5

Echo state graph neural networks with analogue random resistive memory arrays

S. Wang, Y. Li, D. Wang, W. Zhang, X. Chen, D. Dong, S. Wang, X. Zhang, P. Lin, C. Gallicchio, X. Xu, Q. Liu, K. Chen, Z. Wang*, D. S. Shang*, M. Liu

Nature Machine Intelligence (2023) DOI: 10.1038/s42256-023-00609-5

图1 基于随机电阻阵列的回声状态图神经网络学习过程的软-硬协同设计

图2 采用ESGNN实现MUTAG数据集的分子图分类

入选当期封面文章

中国-博士人才网发布

声明提示:凡本网注明“来源:XXX”的文/图等稿件,本网转载出于传递更多信息及方便产业探讨之目的,并不意味着本站赞同其观点或证实其内容的真实性,文章内容仅供参考。